Ética de la Inteligencia Artificial en el periodismo: nos jugamos el futuro de la profesión

Hace un par de años entrevistamos al directivo de una empresa de Inteligencia Artificial (IA) que trabaja en el desarrollo de sistemas automatizados para instituciones y medios de comunicación. Cuando le preguntamos por las implicaciones éticas de la IA en el periodismo, el directivo pasó de puntillas por el tema y se limitó a decir que “no es necesario dar a conocer el algoritmo que usa una empresa porque es como la fórmula de la Coca-cola”. Después hablamos con profesionales de más de 20 medios españoles que usaban algún tipo de IA y me sorprendió que la mayoría también consideraba la ética como una cuestión casi residual. La IA supone un salto cualitativo en el desarrollo tecnológico de los medios. La diferencia radical respecto a etapas anteriores consiste en que estas herramientas son capaces de desarrollar tareas por sí solas, con independencia de la intervención humana. Y sus implicaciones éticas transforman la naturaleza del periodismo tal y como lo conocemos.

Markus Spiske (Pexels)

Markus Spiske (Pexels)

En enero de 2023, BuzzFeed anunció que utilizará la IA para “mejorar” sus contenidos y concursos. El medio nativo digital ha llegado a un acuerdo con la empresa de ChatGPT, Open AI, y empleará esta tecnología para personalizar sus concursos, aportar ideas y generar algunos contenidos informativos. Según The Guardian, el CEO Jonah Peretti lo comunicó a los empleados de BuzzFeed en un correo interno: “En 2023, los contenidos inspirados en la inteligencia artificial pasarán de la fase de I+D a formar parte de nuestra actividad principal, mejorando la experiencia de los concursos, aportando ideas y personalizando los contenidos para nuestros usuarios”. El anuncio disparó el valor de las acciones de BuzzFeed.

La integración de la IA en las redacciones es imparable. En este blog hemos analizado su implantación desde 2019, proporcionando además un listado de recursos para entender su aplicación en los medios o las consecuencias de la desinformación mediante deepfakes cada vez más sofisticados. Además, en enero de 2023, el profesor del MIP Félix Arias recopiló 80 herramientas para generar contenidos de texto, audio, imagen y vídeo mediante la IA.

Ya es habitual que muchos medios utilicen la IA para redactar noticias, gestionar algoritmos, potenciar los servicios de suscripción, procesar cantidades ingentes de datos y generar visualizaciones, entre otras funciones. La implantación de herramientas como ChatGPT, el sistema basado en el modelo de lenguaje por Inteligencia Artificial GPT-3 desarrollado por la empresa OpenAI, puede ayudar a los periodistas (siempre con supervisión) en diversas tareas: resumir documentos, buscar nuevos enfoques, extraer citas, transcribir entrevistas, generar titulares, traducir artículos, redactar correos y textos para redes sociales o contextualizar artículos. Como argumenta Borja Ventura, la IA ya está contribuyendo a mejorar los procesos de documentación, verificación, edición, creación, jerarquización, perfilado y consumo de los contenidos informativos. Además, estos sistemas pueden generar imágenes, editar vídeos o sintetizar conceptos complejos para adaptarlos a distintos tipos de lectores. Sin embargo, el uso de ChatGPT suscita cuestiones éticas, tales como la violación del derecho de autoría, la falta de transparencia en las fuentes empleadas, el plagio o la apropiación indebida de textos, imágenes o vídeos.

Sin embargo, las herramientas de IA distan de ser perfectas. El hecho de que puedan generar falsedades de forma convincente inquieta a los expertos, ya que pueden incrementar la desinformación de forma alarmante. En noviembre de 2022, el medio especializado en tecnología CNET utilizó un generador de textos propio para elaborar artículos sobre finanzas personales, con la finalidad de mejorar su SEO y posicionarse en lo más alto de las búsquedas en Google. Sin comunicar esa novedad a sus lectores, la empresa publicó al menos 77 artículos mediante esta herramienta. A principios de enero, varios investigadores revelaron no solo que CNET había empleado la IA para generar esos artículos, sino que su sistema de gestión de contenidos publicó reiteradamente engaños, errores, plagios e imprecisiones.

Pixabay (Pexels)

Pixabay (Pexels)

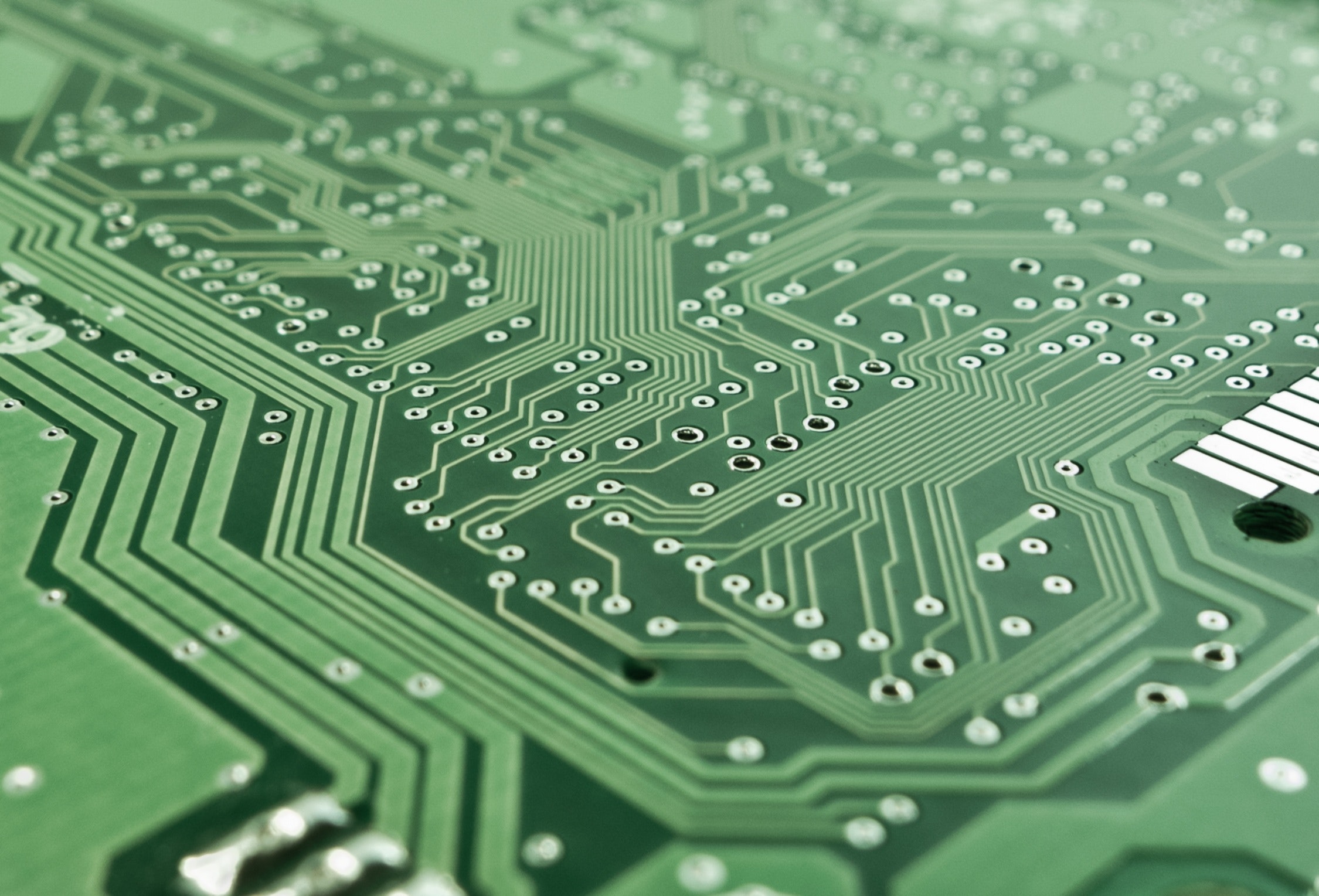

El desarrollo del periodismo automatizado presenta una complejidad notable porque afecta a diversos ámbitos de la organización y en cada uno de ellos se plantean cuestiones éticas, ya que afectan a muchísimos ámbitos de la actividad humana. Como las definiciones de los ámbitos éticos pueden resultar confusas debido a las diversas plataformas existentes, Jeonghye Han, profesora del Departamento de Educación Computacional en Corea, clasifica los ámbitos éticos en función de tres plataformas principales: dispositivos informáticos, plataformas intermediarias y dispositivos físicos. Esta clasificación proporciona un marco ético que abarca la ética de la informática, la ética de la información, la ciber-ética, la ética robótica y la ética de la IA.

Information 2022, 13(9), 440; https://doi.org/10.3390/info13090440

Information 2022, 13(9), 440; https://doi.org/10.3390/info13090440

La complejidad es inmensa. Por un lado, surgen dilemas éticos desde el ámbito de la tecnología, la informática, la robótica, el procesamiento del lenguaje natural, los algoritmos y el Big Data. Por otro, desde el ámbito comercial, sobre la ética de los procedimientos financieros, las vías de ingresos, la captación y mantenimiento de los suscriptores y las estrategias algorítmicas de marketing personalizado. Desde el ámbito periodístico, en el diseño, producción y distribución de contenidos informativos y las prácticas en la gestión de los procesos automatizados. Además, en el ámbito comunicativo destacan las consecuencias de la distribución de informaciones generadas mediante IA, tales como el crecimiento de la desinformación o la creación de ‘burbujas de contenido’ algorítmicas. Se trata de dilemas éticos que han de afrontarse con responsabilidad.

Hasta ahora, la mayor parte de la automatización se ha aplicado en informaciones rutinarias: resúmenes bursátiles, fenómenos naturales, la cobertura de deportes de ligas secundarias o amateurs o informes de resultados de empresas. Sin embargo, de acuerdo con Antonio Ortiz, es previsible que en poco tiempo todo lo humano sea un lujo ya que las tecnologías basadas en IA desempeñarán todo tipo de trabajos, desde atender las llamadas en una empresa hasta servir un pedido en un restaurante de comida rápida.

En febrero de 2022, el Consell de la Informació de Catalunya presentó el informe ‘Algoritmos en las redacciones: retos y recomendaciones para dotar a la Inteligencia Artificial de los valores éticos del periodismo’. El estudio pretende dotar al periodismo de herramientas para convertirse en referente de la tecnoética de la comunicación. La coordinadora del informe, la doctora Patrícia Ventura, subrayaba en un artículo en este blog:

“Si el periodismo tiene que vigilar estos algoritmos o, mejor dicho, a quienes los gestionan, en coherencia deberá estar en condiciones de usar la Inteligencia Artificial de forma ética, ponerla al servicio de su misión de servicio público, dotarla de sus valores y demostrar que es capaz de gestionarla como no lo hacen otros que se limitan a optimizarla con finalidades puramente comerciales y, por lo tanto, sin valores”.

A medida que aumenta el número de medios que recurren a la IA es necesario repensar la ética y la calidad del periodismo computacional y de todo lo que implica en los procesos de captación, producción, edición y distribución de informaciones. Está claro que las empresas periodísticas deben plantearse importantes cuestiones éticas derivadas del uso de la IA y saldrán perdiendo si no lo hacen desde ya. En este ámbito hay muchas zonas grises y amplio margen para el contraste de posturas, por lo que asistimos a un proceso complejo de toma de decisiones que debe incluir la perspectiva ética. ¿Qué problemas crean los sistemas automatizados? ¿Qué situaciones deben preocuparnos?

Tara Winstead (Pexels)

Tara Winstead (Pexels)

Hemos elaborado un listado de preguntas orientativas sobre las implicaciones éticas del periodismo automatizado. Se basa en las aportaciones de Thomas Kent, veterano editor de la agencia Associated Press y asesor de la Red de Periodismo Ético, y en las conversaciones con profesionales de medios españoles que han implementado algún tipo de IA, mantenidas junto con los colegas Alicia de Lara y Félix Arias. Lo dividimos en cuatro fases del proceso productivo: Preproducción; Producción; Valoración informativa, y Cuestiones a posteriori.

1. Preproducción

-

¿Cuál es la precisión de los datos subyacentes? Los datos que utiliza la herramienta, ¿proceden de fuentes de información contrastada como empresas, bolsas, administraciones o instituciones públicas? Si los datos no proceden de fuentes autorizadas, ¿cómo puedes asegurarte de que son fiables?

-

¿Tienes los derechos sobre los datos? ¿Tiene el proveedor de los datos derecho legal a enviártelos? ¿Cuentas con permiso para publicarlos? Los lectores considerarán al medio responsable de los datos, sea cual sea la fuente original.

-

Algunos sistemas automatizados crean presentaciones de vídeo o fotos para acompañar los textos. ¿Puedes estar seguro de que el sistema accede sólo a las imágenes para cuyo uso tiene derecho legal? ¿Cómo asegurarse de que no utiliza imágenes hirientes o de mal gusto?

-

¿Qué medidas de seguridad puedes adoptar para comprobar la veracidad, exactitud y sesgos de los contenidos generados por IA, antes de su publicación?

2. Producción

- ¿Qué datos destacará el sistema de IA? Por ejemplo, en una noticia que resuma el día en los mercados, ¿con qué valores e índices empezará la herramienta? ¿Comparará las últimas cifras con las de principios de año o con las de hace cinco años?

- ¿Quién y cómo se supervisa la herramienta? Los errores con los datos subyacentes o el software de automatización pueden generar fallos rápidamente. Comprueba el sistema de automatización: que un editor revise cada pieza antes de publicarla.

- ¿Los informes automatizados coinciden con el estilo habitual en la publicación? La ortografía y el estilo de redacción deben coincidir con el resto del medio. Los lectores se sentirán confundidos por un contenido que desentone con su estilo periodístico.

- ¿Qué pasa con el mantenimiento a largo plazo? Las redacciones deben mantener regularmente sus equipos de IA y supervisar el trabajo de los algoritmos.

Andrea Piacquadio (Pexels)

Andrea Piacquadio (Pexels)

3. Valoración informativa

- ¿Es el tema apropiado para la automatización?

- ¿La cobertura de qué temas vas a automatizar? Antes de “enchufar” una fuente de datos, piensa si es deseable que todo fluya automáticamente, sin apenas supervisión.

- ¿Revelarás que estás usando la IA? ¿Serás transparente en todo el proceso?

- ¿Usarás algoritmos que puedan distorsionar intencionadamente la cobertura y, en caso afirmativo, lo revelarías?

- ¿Vas a reducir el personal humano? Muchos medios que usan la automatización afirman que su objetivo no es sustituir a los periodistas por robots, sino permitir que su personal se centre en la información relevante y evite las tareas rutinarias. Pero si se contratan menos periodistas porque hay que invertir en IA, surge un problema.

4. Cuestiones a posteriori

- ¿El sistema registra todos los pasos utilizados para crear cada pieza?

- Si alguien cuestiona la veracidad de una pieza generada mediante IA, ¿puedes dar una explicación u obtener una respuesta de los proveedores de datos y de automatización? ¿Puedes defender cómo se elaboró cada pieza?

- ¿Tienes los procesos automatizados lo suficientemente bien documentados como para que, incluso cuando cambie el personal humano o la plantilla del algoritmo, poder explicar cómo se gestionó cada pieza?

- ¿Y si te demandan? Imagina a las partes de un proceso judicial exigiendo el código fuente de la automatización. ¿Lo revelarás o lo defenderás como secreto profesional?

Las implicaciones éticas de la IA en las redacciones presentan un componente multidisciplinar, fruto de su complejidad, por lo que conviene sopesar las diferentes perspectivas. Esta complejidad puede contribuir a generar tensiones, por ejemplo, entre el departamento comercial y el editorial, entre el equipo técnico y el periodístico, entre los medios y los usuarios. Al mismo tiempo, surgen zonas grises donde los criterios éticos no parecen claros y abundan los matices, precisamente por la naturaleza compleja del fenómeno.

La ética en el uso de la IA puede convertirse en un valor estratégico para las empresas de comunicación, que contribuya a superar la crisis generada por la incertidumbre sobre el modelo de negocio, la pérdida de confianza por parte de los lectores o el incremento de la desinformación. Como apuntaba en este blog, debemos tener en cuenta la ética de los fines (¿Para qué lo hago?), de los procedimientos (¿Cómo lo hago?) y de los valores (por qué lo hago). Porque no cabe un periodismo innovador que no sea ético, nos jugamos el futuro de la profesión si no actuamos con transparencia y responsabilidad.